Une nouvelle représentation sphérique frugale en vision à 360 degrés pour la robotique

Équipé de deux caméras fish-eye, un robot va être capable de voir à 360 degrés. Ces systèmes de vision sont cependant lourds à traiter à cause des multiples distorsions qu’ils engendrent. Des chercheurs ont conçu un nouvel algorithme, qui permet à différents robots d’accomplir efficacement des tâches types malgré une résolution visuelle minimale. Publiés dans IEEE Transactions on Robotics, ces travaux réduisent fortement la mémoire et la puissance nécessaires pour la vision des robots.

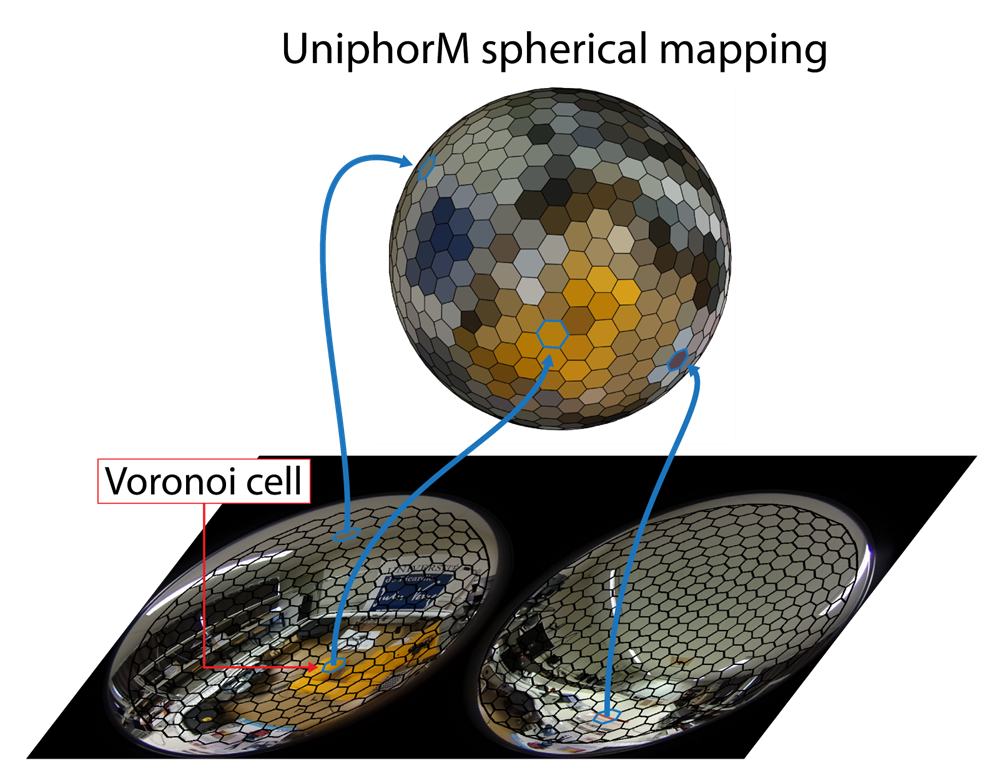

Les caméras fish-eye duales compactes existent depuis près de dix ans et offrent un champ de vue sans limite à 360 degrés. Leur résolution, toujours en croissance, atteint aujourd’hui jusqu’à 70 millions de pixels et donne un excellent champ de vision à différents types de robots. Mais comme ces images à 360 degrés sont projetées sur un plan pour être traitées, elles induisent de nombreuses distorsions, de la même manière que lorsque l’on veut aplatir une carte du monde à partir d’un globe terrestre. Le traitement de ces distorsions peut se révéler particulièrement lourd pour des applications en temps réel. Des chercheurs du Joint Robotics Laboratory (JRL, AIST/CNRS) et du laboratoire Modélisation, information & systèmes (MIS, Université de Picardie Jules Verne) ont proposé un nouveau type de représentation sphérique, appelé Uniform spherical mapping of omnidirectional images (UniphorM), où ils transforment les images acquises vers un type de maillage sphérique régulier d’une géométrie jusque-là marginale dans l’état de l’art. Ils ont ainsi montré qu’une réduction significative de la résolution, à moins de 1000 pixels seulement, permet à un robot d’estimer son orientation dans l’espace et de reconnaître des lieux aussi bien qu’à des résolutions bien supérieures, pour une complexité algorithmique et une occupation mémoire minimales.

Les scientifiques ont obtenu ce résultat en appliquant leurs calculs directement sur la sphère, en la subdivisant et en assignant chaque pixel comme un de ses sommets. La sphère est pour cela approximée en un icosaèdre, un solide à vingt faces. Cette approche a été validée sur plusieurs types de robots. On compte ainsi deux drones aériens, un hexacoptère et une aile volante, un bras robotique à six degrés de liberté, et des robots mobiles. Ces différentes machines ont été capables de réaliser deux tâches importantes en robotique, qui sont d’estimer leur orientation dans l’espace et de reconnaître des lieux. La première consiste à réaligner ses deux images sphériques pour retrouver un ensemble droit, ce qui s’est ici fait avec 95 % de réussite. La reconnaissance de lieux consiste à être capable de reconnaître les images d’un parcours dans des conditions différentes d’éclairage, d’heure, de météo… Une tâche où le nouvel algorithme s’est révélé 40 % plus efficace que l’état de l’art. La basse résolution employée est d’ailleurs compatible avec le respect de la vie privée, puisqu’elle ne permet pas de reconnaître des visages.

Les chercheurs s’intéressent à présent à une nouvelle tâche importante en robotique : l’asservissement visuel. Il s’agit de prendre une image à une position désirée, et de contrôler le mouvement du robot pour rejoindre cette position depuis une autre.

© Antoine André

Références

A. André, F. Morbidi, G. Caron.

UniphorM: A New Uniform Spherical Image Representation for Robotic Vision.

IEEE Transactions on Robotics, vol. 41, pp. 2322-2339, 2025.

https://doi.org/10.1109/TRO.2025.3547266

Article disponible sur la base d’archives ouvertes HAL