Vers une IA plus efficace

Les systèmes analogiques promettent une IA plus rapide et plus efficace sur le plan énergétique, mais leur entraînement rencontre des difficultés que n’ont pas les réseaux numériques. Une équipe franco-suisse a fait fonctionner des réseaux neuronaux physiques en se passant de rétropropagation (méthode de calcul du gradient de l'erreur pour chaque neurone du réseau), car ce principe est difficile à implémenter dans le monde analogique. Publiés dans la revue Science, ces travaux lèvent un verrou important pour le développement des systèmes d’IA analogiques.

Approche devenue centrale dans le monde de l’IA, l’apprentissage automatique fonctionne à partir de puces numériques. Les réseaux neuronaux physiques (PNN), basés sur des composants analogiques, suscitent cependant l’intérêt des chercheurs pour leur consommation énergétique réduite et leur vitesse de calcul accélérée. Mais le numérique reste favorisé car certaines de ses fonctions n’ont pas d’équivalents analogiques. Ainsi, l’entraînement des systèmes d’apprentissage automatique requiert généralement des algorithmes de rétropropagation des erreurs, qui comparent l’écart entre une prédiction et la réalité afin d’ajuster rétroactivement le « poids » des synapses du réseau. Utiliser ce principe de manière analogique réclame un double numérique de la couche de matériel analogique, dont le coût élevé risque d’annuler les avantages de l’analogique. À noter également que si l’apprentissage automatique s’inspire du cerveau humain, ce dernier semble pourtant fonctionner sans rétropropagation des erreurs. Des chercheurs de l’Institut d’électronique et des technologies du numérique (IETR, CNRS/CentraleSupelec/INSA Rennes/Nantes Université/Université de Rennes) et de l’École polytechnique fédérale de Lausanne (EPFL, Suisse) ont conçu des réseaux neuronaux physiques qui s’entraînent sans rétropropagation des erreurs.

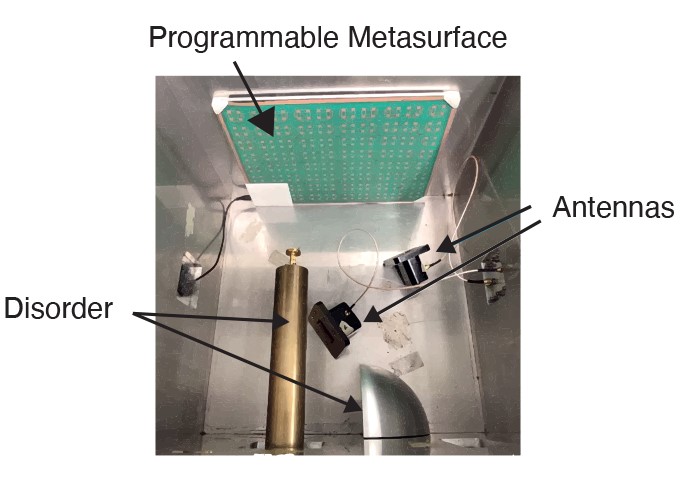

Dans cette étude, les scientifiques ont construit différents algorithmes d’apprentissage basés sur des composants analogiques, répondant à des ondes telles que la lumière, le son ou les micro-ondes. Ces systèmes hybrides combinent une architecture numérique de réseau de neurones profonds à un réseau physique et analogique d’apprentissage. Les algorithmes y sont entraînés en disposant de contre-exemples bien identifiés de la tâche à accomplir, ce qui leur permet de comparer la qualité des résultats sans avoir à procéder à de la rétropropagation d’erreurs. Cette approche fonctionne sans connaissance a priori du matériel physique, surtout si celui-ci offre des réponses non linéaires, c’est-à-dire que ses signaux en sortie ne sont pas proportionnels à ceux en entrée. Les chercheurs ont ensuite testé leurs différentes couches physiques avec succès sur des tâches standardisées de classification d’images, couramment utilisées pour comparer les performances des algorithmes. L’équipe compte à présent miniaturiser leurs systèmes et aller vers des solutions avec une plus grande part analogique.

© Ali Momeni et al.

Références

Backpropagation-free Training of Deep Physical Neural Networks.

Ali Momeni, Babak Rahmani, Mathieu Malléjac, Philipp del Hougne, Romain Fleury.

Science, 23 Nov 2023.

https://dx.doi.org/10.1126/science.adi8474

Article consultable sur les bases d’archives ouvertes Arxiv et HAL